As decisões baseadas em dados têm sido um fato desde o início da Pomelo. E é por isso que decidimos ir além: para construir um modelo revolucionário que não apenas recomenda a fonte de dados mais adequada para cada necessidade, mas também aborda a segurança, a certificação e a validação de dados de forma abrangente e automatizada.

A evolução para uma abordagem orientada por dados é iminente e a governança está se tornando cada vez mais crucial tanto para as equipes de dados quanto para os usuários, por isso é importante estar à frente das tendências emergentes e aplicá-las de forma a beneficiar as empresas.

Você provavelmente já deve estar se perguntando: como eles integram um sistema de recomendação ao Tableau, conseguiram incorporar um modelo de IA, quais eficiências essa implementação trouxe? Neste artigo, contamos a você como fizemos isso na Pomelo.

Transformando o gerenciamento de dados

Ao adotar uma abordagem orientada por dados, as empresas não apenas aprimoram a tomada de decisões estratégicas, mas também democratizam o acesso às informações. Essa mudança de paradigma está impulsionando um aumento no uso de ferramentas analíticas. Nesse contexto, o Tableau se destaca como uma poderosa plataforma de visualização na Pomelo, assim como em muitas outras empresas.

Reconhecendo que o Tableau não é apenas uma ferramenta interna, mas também afeta diretamente a experiência de nossos clientes por meio dos painéis disponíveis, temos o compromisso de mantê-lo em ótimas condições. No entanto, esse compromisso não se limita à simples manutenção do software, mas nos leva a buscar constantemente melhorias e eficiências.

Enfrentamos um grande desafio: a criação de um sistema de recomendação e automação integrado ao Tableau, projetado para revolucionar a maneira como as pessoas interagem e melhorar a eficiência e a experiência do usuário.

Primeiros passos

Para enfrentar esse desafio, começamos analisando a infraestrutura do Tableau Server em profundidade. Como as primeiras etapas de nossa estratégia de automação, nos concentramos no desenvolvimento da automação, usando as APIs do Tableau para fornecer processos que alcançariam os seguintes resultados:

- a substituição segura de credenciais;

- detecção proativa de incidentes;

- a modificação das frequências de execução de tarefas;

- alertas e mensagens automáticas sobre o status de integridade do servidor e do cluster;

- processos regulares de limpeza e manutenção, entre outros.

Essas soluções iniciais não apenas melhoraram a eficiência operacional, mas também nos aproximaram da conformidade com os padrões de governança de dados. Além disso, elas nos forneceram uma visão holística do desempenho do Tableau Server, garantindo que ele estivesse operando com desempenho máximo o tempo todo.

Análise de fontes de dados?

Reconhecendo a importância das fontes de dados no Tableau, bem como o acesso à certificação e à validação desses dados por um profissional, como pilares fundamentais para preservar sua integridade e confiabilidade, nos propusemos a dar um passo além. Nos desafiamos a desenvolver um sistema que não só garantisse a certificação profissional de nossas fontes de dados, mas também revolucionou a forma como interagimos com as informações, fornecendo recomendações e sugestões, entre outras funcionalidades.

Contando com o acesso aos valiosos metadados do Tableau e aproveitando as sólidas habilidades em Python de nossa equipe de business intelligence, criamos e desenvolvemos um primeiro processo que realiza uma análise profunda de seus atributos:

- Quanto pesava o extrato?

- O número de linhas foi consistente?

- Ele tinha uma nomenclatura apropriada de acordo com os padrões de qualidade?

- As atualizações foram configuradas corretamente?

- A extração estava funcionando corretamente?

Depois de validar automaticamente todas essas incógnitas, tivemos uma resposta clara sobre seu status e adequação em menos de um minuto. Essa automação melhorou a eficiência da equipe e também capacitou os usuários com respostas rápidas e precisas, facilitando o uso ágil e confiável dos dados.

E como chegamos ao sistema de recomendação?

Até então, havíamos obtido eficiência em diferentes aspectos com os processos e as automações que implementamos. No entanto, ainda não tínhamos resolvido o grande problema que todos nós enfrentamos no Tableau Server: fontes de dados duplicadas, semelhantes, confusas e desconhecidas em todos os projetos. Esse desafio deu origem ao sistema de recomendação que proporciona uma experiência de valor inovadora, além de simplificar e eliminar completamente as tarefas manuais relacionadas à análise de fontes de dados.

Em seguida, nos deparamos com o desafio de integrar tudo o que havíamos desenvolvido até então com um modelo que era completamente novo para nós. Embora tenham surgido várias alternativas, estávamos determinados a encontrar uma que pudesse se integrar ao nosso processo e cujos resultados pudessem ser modelados com precisão. Identificamos que o Python seria a escolha certa para desenvolver e implementar a lógica necessária. No entanto, nos perguntamos o que mais deveríamos considerar.

Bancos de dados vetoriais?

A questão de quais dados precisávamos analisar guiou nosso caminho para a solução final. A maioria dos dados viria do Athena, do PostgreSQL e de outros sistemas de armazenamento que alimentam nosso lago de dados. Surgiu, então, a necessidade de uma infraestrutura capaz de lidar com esses dados de forma eficiente e dimensionável. Assim, começamos a considerar a implementação de bancos de dados vetoriais.

Esses bancos de dados representam uma maneira inovadora de armazenar e gerenciar informações, especialmente ao lidar com dados de alta dimensão. Diferentemente dos bancos de dados tradicionais, que armazenam dados em tabelas bidimensionais, os bancos de dados vetoriais são projetados para trabalhar de forma eficiente com dados que podem ser representados como vetores numéricos. Com isso, é possível processar e analisar grandes volumes de dados com mais eficiência e rapidez do que os bancos de dados tradicionais, o que os torna particularmente adequados para ambientes com dados complexos e de alta dimensão.

Depois de considerar várias opções, escolhemos o Chroma como nossa solução. O Chroma é um banco de dados vetorial que oferece desempenho excepcional e flexibilidade notável para trabalhar com dados de alta dimensão. Sua capacidade de lidar com grandes volumes de dados e sua eficiência no processamento de consultas o tornaram a escolha ideal para o nosso projeto. Mas o que realmente se destacou em nossa escolha foi sua capacidade de se integrar perfeitamente a modelos avançados de processamento de linguagem natural.

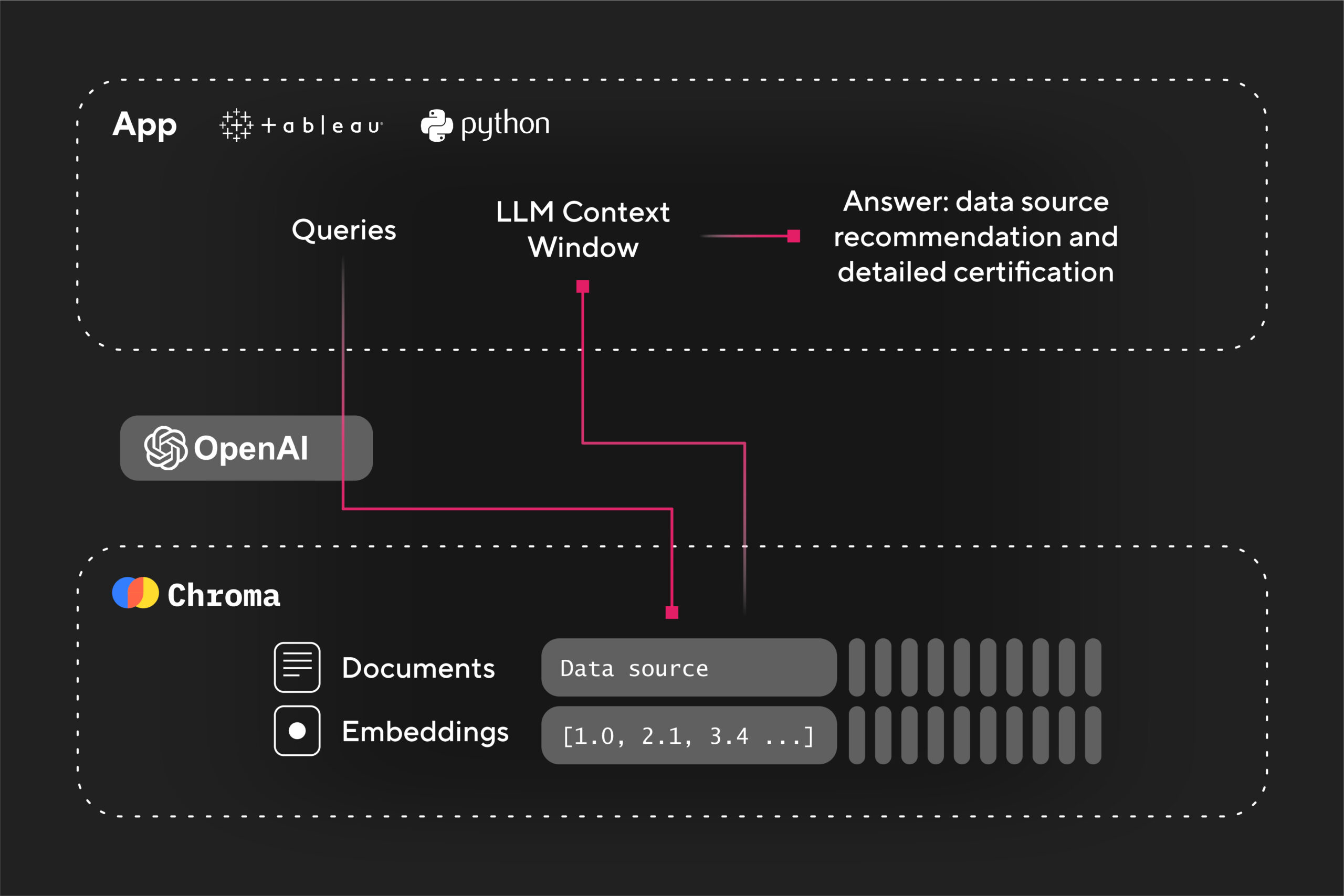

Em seguida, para aprimorar ainda mais essa combinação, incorporamos o OpenAI como um mecanismo junto com o Chroma.

OpenAI e Tableau juntos?

Sim! As automações do Tableau que criamos no início evoluíram a ponto de agora serem alimentadas pela inteligência artificial da OpenAI. Mas como isso funciona? Vamos explicar passo a passo:

- O processo recebe a fonte de dados do Tableau que queremos consultar.

- O Chroma examina o banco de dados de vetores em busca de vetores disponíveis, certificados e em produção.

- Em seguida, o processo interage com o OpenAI e fornece resultados que formatamos automaticamente em Python.

- Por fim, geramos respostas em linguagem natural com recomendações sobre qual fonte de dados do Tableau deve ser usada e as porcentagens de similaridade entre elas.

A sinergia entre o Chroma e o Open AI nos permitiu alcançar níveis sem precedentes de eficiência e precisão no gerenciamento de dados, abrindo caminho para uma tomada de decisão mais informada e estratégica. Transformamos processos manuais que costumavam levar até duas horas de trabalho em uma tarefa automatizada em apenas dois minutos. Além disso, essa solução está pronta para lidar com todas as declarações, desde as iniciais até as que são adicionadas ao longo do tempo, complementando o conhecimento interno da equipe e permitindo que a IA assuma essa responsabilidade.

Graças a essa integração, as validações e sugestões agora são realizadas instantaneamente e com precisão, simplificando nosso fluxo de trabalho e garantindo a qualidade eficiente dos dados. Desde sua implementação, esse processo se tornou padrão para todas as novas fontes de dados, contribuindo para que mais de 38% fossem submetidos ao novo fluxo antes de entrar em operação.

Chegamos ao fim!

O processo alcançado agrega valor a todos, fornecendo métricas mais rápidas, confiáveis e seguras. Isso se traduz em maior satisfação do cliente, pois ele recebe informações precisas e acesso a dados relevantes e confiáveis para suas decisões.

Essa abordagem inovadora não se limita ao Tableau; seu potencial pode ser estendido a outros produtos de dados. Uma próxima etapa poderia envolver a integração dessa solução à nossa estratégia de malha de dados, o que nos permitiria replicar e escalonar esse gerenciamento eficiente de dados em todo o nosso ecossistema de informações.